¿Alguna vez te has preguntado cuánto le cuesta a una empresa un falso positivo en la línea de producción? ¿Y una parada no planificada? Todo empieza con esa pregunta… y si sigues leyendo, descubrirás por qué.

Durante años, automatizar significaba repetir. Las máquinas eran precisas, sí, pero ante cualquier cambio en la iluminación o el ángulo de una pieza, el proceso fallaba. Cada ajuste en las condiciones del entorno podía generar un error, y lo que parecía una mejora en eficiencia se convertía en una limitación.

Pero, ¿y si las cámaras pudieran superar esa barrera? ¿Qué pasaría si, en lugar de simplemente capturar píxeles, pudieran «entender» lo que ven, adaptándose a los cambios del entorno de manera similar al ojo humano?

Este es el pilar de la Fábrica Inteligente [1]. Gracias a la Visión Artificial y el Deep Learning, es posible conseguir que las máquinas “entiendan” lo que ven. Este avance no viene solo a mejorar la precisión, sino a eliminar la incertidumbre: sistemas que dejan de limitarse a medir para empezar a interpretar, siendo capaces de distinguir un defecto real de una simple mancha o guiar a un robot en entornos cambiantes, adaptándose por fin a la realidad de las fábricas y no al revés.

En sus inicios, la visión artificial tradicional funcionaba bajo órdenes estrictas: busca un borde de X píxeles o detecta este color exacto, y, aunque este enfoque sigue siendo útil en entornos controlados, tiene un punto débil: la fragilidad. Un reflejo, un cambio de luz o vibraciones en la cámara bastan para que el sistema se confunda [2].

Aquí es donde el Deep Learning marca la diferencia [2]. Gracias a las redes neuronales, el sistema no sigue reglas fijas, sino que aprende patrones directamente de los datos. Tras entrenar estos modelos con un gran número de imágenes de ejemplo, el modelo crea su propia lógica para identificar productos o defectos, haciendo que una iluminación variable o una pieza mal colocada dejen de ser un problema: el sistema sabe lo que busca, sin importar las condiciones.

Imagen: How defect detection with computer vision works

A medida que el Deep Learning se ha consolidado en la industria, también han surgido nuevos desafíos como la falta de datos, la necesidad de respuestas más rápidas o la complejidad de los entornos industriales, que han impulsado el desarrollo de nuevas tendencias en IA y visión artificial. Algunas de ellas son:

IA Generativa y datos sintéticos. Como se ha mencionado anteriormente, para que un modelo de Deep Learning aprenda a distinguir defectos como rayas, deformaciones, arañazos, manchas, errores de ensamblaje, necesita ver un gran número de ejemplos previamente. Sin embargo, conseguir estas imágenes con todas sus variaciones posibles (cambios de luz, ángulos, texturas) no es siempre sencillo.

Es aquí donde entra en juego la IA Generativa. Mediante tecnologías como Redes Generativas Antagónicas (GANs) o modelos de difusión, es posible crear datos sintéticos: imágenes fotorrealistas con las que se pueden simular todas estas variaciones necesarias para alcanzar un modelo robusto aun sin gran variedad de imágenes reales, reduciendo los tiempos de implementación y acelerando el desarrollo del sistema [3]. Para sectores como automoción, electrónica o packaging, se ha convertido en una herramienta esencial para acelerar la puesta en marcha de sistemas de visión complejos.

Modelos de Lenguaje y Visión. La segunda tendencia clave es la integración de modelos capaces de combinar visión y lenguaje. En lugar de limitarse a clasificar o detectar objetos, pueden razonar sobre lo que ven, explicar qué lo causa, evaluar su gravedad y hasta proponer una acción recomendada. Gracias a ello, pueden proporcionar un diagnóstico en tiempo real del problema a partir de una simple pregunta del operario. Además, son muy útiles para generar informes automáticos, asistir en tareas de mantenimiento o servir de interfaz natural entre personas y sistemas automáticos [4].

Edge AI. Debido a la necesidad creciente de que todo sea inmediato, en muchos procesos es necesario tomar decisiones en milisegundos: expulsar una pieza defectuosa, detener una máquina, ajustar la trayectoria de un robot o sincronizar una celda de producción ha impulsado el uso de Edge AI. Gracias a cámaras inteligentes y dispositivos embebidos de alta potencia, los algoritmos se ejecutan directamente en el dispositivo [5]. Esto permite mayor velocidad en las respuestas, más privacidad y funcionamiento sin conexión a internet, convirtiéndose en un estándar en entornos donde cada milisegundo es crítico.

Visión 3D. Después de muchos avances en el campo de la visión 2D, comprender solo la imagen plana ya no es suficiente. El siguiente paso es que las máquinas comprendan la geometría real de los objetos (formas, volúmenes, posiciones exactas en el espacio). Esto es posible gracias a la combinación de las nubes de puntos 3D generadas por tecnologías como LiDAR, Tiempo de Vuelo (ToF) o visión estéreo con la IA. Con esta información es posible distinguir entre defectos superficiales y deformaciones volumétricas, medir con gran precisión y entender la orientación espacial de piezas complejas.

La aplicación más representativa de esta tendencia es el Bin Picking [6]. Esta se basa en enseñar a un robot a “ver” un contenedor con piezas desordenadas, que identifique cada una, calcule su orientación y la agarre de forma óptima.

Visión multiespectral e hiperespectral. Del mismo modo, han surgido nuevos retos relacionados con el análisis de las propiedades internas de materiales, como su composición química, humedad, desgaste o temperatura, cuya solución está más allá del espectro visible. Por ello, las cámaras capaces de captar información en infrarrojo, ultravioleta, térmicas o incluso en cientos de bandas espectrales simultáneas han adquirido gran relevancia [7].

Esta tecnología se aplica principalmente en mantenimiento, para detectar puntos calientes en motores o cuadros eléctricos, y también para diferenciar materiales que parecen idénticos a simple vista, clasificar alimentos según su madurez o identificar impurezas o defectos internos [7].

Visión Transformers (ViT). Detectar defectos diminutos en superficies complejas, como metales pulidos, placas electrónicas o materiales compuestos, sigue siendo un desafío para la visión industrial tradicional. Los Vision Transformers (ViT) representan una evolución del Deep Learning que aborda este problema. Gracias a su capacidad para captar relaciones globales en la imagen, ofrecen una mayor precisión y reducen los falsos positivos, lo que resulta crítico en sectores con altos estándares de control de calidad [8].

Gemelos Digitales y visión. En muchos casos es difícil anticipar fallos en máquinas, líneas o sistemas completos, lo que provoca paradas inesperadas y costes elevados. Para ello, surgen los Gemelos Digitales: réplicas virtuales interactivas de equipos o procesos que se alimentan de datos reales. Aquí es donde la visión se convierte en sus “ojos”. Las cámaras monitorizan vibraciones, desgaste, velocidad, geometría de piezas e incluso microdefectos, otorgando la información necesaria para que el Gemelo Digital simule el estado futuro del sistema [9].

Por ejemplo, si detecta que una cinta transportadora vibra un 5 % más de lo normal, la IA calcula la probabilidad de fallo y estima cuándo podría ocurrir. En cuanto el margen se vuelve crítico, se genera una orden de mantenimiento preventiva, ayudando a reducir las paradas no planificadas.

IA para la colaboración humano–robot y la seguridad. Otra tendencia creciente es el uso de visión e IA como para proteger a las personas y mejorar la colaboración con robots y máquinas. Entre sus aplicaciones más destacadas se encuentran:

- Robots colaborativos: reducción de su velocidad y detención automática cuando una persona entra en su zona de trabajo, gracias a la estimación de pose y a la detección de presencia humana [10].

- Cumplimiento de EPIs: verificación en tiempo real del uso de cascos, chalecos, guantes o gafas.

- Análisis ergonómico: identificación de posturas de riesgo y tareas repetitivas, proponiendo mejoras para prevenir lesiones.

Así, la visión industrial deja de centrarse únicamente en el producto y empieza a focalizarse también en la seguridad y el bienestar de las personas.

La Visión Artificial ha evolucionado de la simple inspección a la interpretación y anticipación, transformando la producción industrial. Lo que comenzó como un esfuerzo por detectar defectos se ha convertido en un ecosistema de tecnologías que aceleran la puesta en marcha de sistemas, permiten decisiones en milisegundos y capturan la geometría y composición interna de los materiales. La integración de IA y visión industrial no solo mejora la calidad, sino que transforma el funcionamiento de las fábricas, haciéndolas más seguras, eficientes e inteligentes.

Gracias por acompañarnos en este recorrido por las tecnologías que están redefiniendo el sector industrial. Esperamos que este viaje, desde el simple “ver” hasta el “entender y anticipar”, inspire a transformar sus procesos. La Fábrica Inteligente no es una visión futurista, sino una realidad actual, esperando a ser construida.

Referencias:

[1] Qué es una Smart Factory y en qué consiste la fabricación inteligente | UNIR

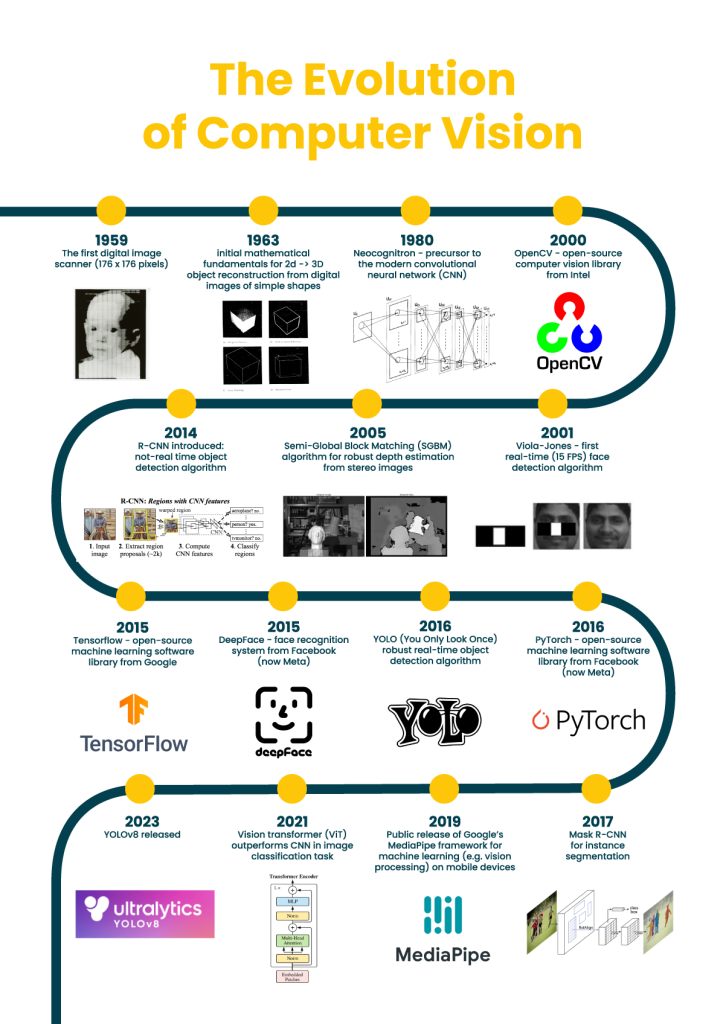

[2] Historia de Vision AI: De la detección de bordes a YOLOv8

[3] La inteligencia artificial generativa y su impacto en la creación de contenidos mediáticos

[4] https://arxiv.org/pdf/2501.02189

[5] https://arxiv.org/pdf/2407.04053

[7] https://www.haip-solutions.com/hyperspectral-cameras/blackindustry-swir/

[8] https://www.ultralytics.com/es/glossary/vision-transformer-vit

[9] https://es.mathworks.com/campaigns/offers/next/digital-twins-for-predictive-maintenance.html

[10] https://www.tekniker.es/es/la-seguridad-en-entornos-colaborativos-persona-robot